In einigen Diskussionsrunden, Social-Media Threads (vgl. ff.) äußerte ich in der Vergangenheit hin und wieder mal die Behauptung, die einzige Möglichkeit der Datenübertragung von A nach B, die nicht mitgelesen werden könne (gemeint ist das Mitlesen der Daten auf dem Wege eben von A nach B), sei diejenige mittels der sog. Quantenkryptographie. Als ich dann noch eins draufsetzte und behauptete, dies sei absolut sicher 😯, ging’s zumeist erst so richtig los. „Absolute Sicherheit gibt es nicht!“ lautete da der standardmäßige lapidare Einwand. Die etwas mehr Bewanderten in der Materie haben mich sodann mit zahlreichen Links überhäuft, die belegten (was nicht überrascht), dass jede (konventionelle) Datenübertragung – egal wie verschlüsselt diese sein mag – nicht absolut sicher sein kann, sofern irgendeine Möglichkeit besteht, den Datenstream irgendwie mitzulesen. Genau dieses Missverständnis will ich zunächst im vorliegenden Beitrag auflösen.

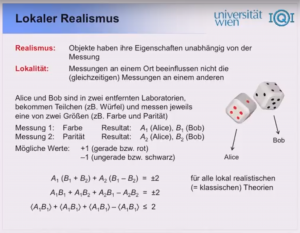

Unter den Links und Quellen, die mich erreichten, fand sich auch der Vortrag „J. Kofler @ Club IT UBIT Wien Mai 2011 – Quantencomputer und Quantenkryptographie“ von Dr. Johannes Kofler, der im Anschluss an den vorliegenden Beitrag als Youtube-Plugin verlinkt ist und aus dem ich mir erlaube, wörtlich und bildhaft hin und wieder mal zu zitieren. Der Vortrag von J. Kofler gibt eine sehr anschauliche Einführung in die Materie, in die quantenmechanischen Grundkonzepte, wie Superposition, Verschränkung, Bellsche Ungleichung etc. und ist von daher als Ganzes auch und gerade für Einsteiger sehr zu empfehlen.

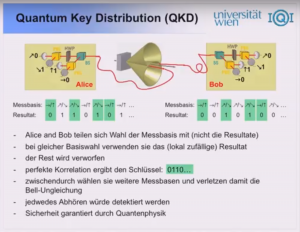

Für uns beginnt es etwa ab der 25. Minute besonders interessant zu werden, als es eben um das Verfahren zur Erstellung und Übertragung von kryptografischen Schlüsseln (sog. Quantum Key Distribution, QKD) geht, das aufgrund des EPR-Effektes ➡ und eingedenk Bellscher Ungleichung als absolut sicher anzusehen ist – wohl gemerkt trifft es auf die „Erstellung und Übertragung“ eines kryptografischen Schlüssels zu, jedoch nicht auf die Verschlüsselung selbst.

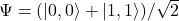

➡ Der sog. Einstein-Podolsky-Rosen Effekt (lt. Einstein „spukhafte Fernwirkung“ 👿 ) wurde seinerzeit im Zuge eines Gedankenexperimentes angedacht und später mehrfach bestätigt. Eine Gruppe von Objekten (Teilchen), in einfachsten Falle ein Paar davon, kann miteinander „verschränkt“ sein, sich also im Zustand perfekter Korrelation befinden, z.B.  , was soviel bedeutet, wie dass die Messung an einer Observablen (z.B. Polarisationsebene eines Photons) eines beliebigen Teilchens in dem (verschränkten) Paar stets das gleiche Resultat hervorbringt, wie bei dem anderen Teilchen. Dabei spielt weder der Zeitpunkt, noch die Reihenfolge der Messung, noch die Entfernung der Teilchen voneinander eine Rolle. Die Zustandsveränderung tritt sofort ein und ist an die Lichtgeschwindigkeit nicht gebunden.

, was soviel bedeutet, wie dass die Messung an einer Observablen (z.B. Polarisationsebene eines Photons) eines beliebigen Teilchens in dem (verschränkten) Paar stets das gleiche Resultat hervorbringt, wie bei dem anderen Teilchen. Dabei spielt weder der Zeitpunkt, noch die Reihenfolge der Messung, noch die Entfernung der Teilchen voneinander eine Rolle. Die Zustandsveränderung tritt sofort ein und ist an die Lichtgeschwindigkeit nicht gebunden.

.

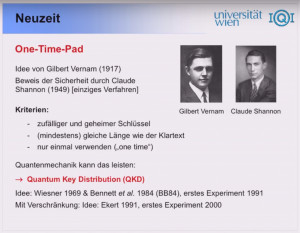

Und hier liegt schon mal die erste Quelle von einer Reihe an Missdeutungen und Missinterpretationen meiner Äußerungen. Ich habe natürlich nie behauptet, dass die EPR-Sicherheit (selbst diese will ich nicht als „absolut“ bezeichnen) von QKD automatisch eine Sicherheit der anschließenden Datenübertragung selbst bedeutet. Der Grund ist schlicht der, dass wir diesen sicheren (von mir aus „absolut sicheren“) Schlüssel erst in „normalen“ Verschlüsselungsverfahren zu verwenden haben – z.B. in dem „OTP“ = One-Time-Pad – und ab da weist die Verschlüsselung ja genau die gleiche, mitnichten „absolute“ Sicherheit auf, wie ein konventionell generierter, hinlänglich zufälliger Schlüssel ➡. Gemeint habe ich vielmehr eine „absolute“ Sicherheit bei Verwendung des EPR-Effektes für die Datenübertragung selbst.

Allerdings erlebte ich hier erst mal den X-Generation-Effekt. Denn gefragt nach dem konkreten Link hierfür bin ich im WWW schlicht nicht fündig geworden, was möglicherweise damit zusammenhängt, dass ich es mit der Y-Generation eindeutig nicht mehr aufnehmen kann; beim Googeln schon gar nicht.

➡ Bei dem Verweis darauf, dass der Beweis von Claude Shannon fürs OTP nicht mit absoluter Sicherheit desselben gleichzusetzen sei, rennt Ihr bei mir wie gesagt offenen Türen ein. Allerdings erlebte ich einmal auf Facebook eine gegenteilige Behauptung, frei nach dem Motto, OTG ist doch nachweislich sicher, also braucht man den ganzen QKD-Quatsch gar nicht. Letzterem will ich entgegnen (und somit den ersteren beipflichten), dass Shannons Beweis lediglich eine algorithmische Nicht-Entschlüsselbarkeit unter den 3 genannten Kriterien (Zufälligkeit, Schlüssel-Mindestläge, einmalige Verwendung) bedeutet. Sein Beweis besagt jedoch nichts über Erfolgsaussichten eines wie auch immer gearteten heuristischen Ansatzes in einem konkreten Fall, eines probabilistischen oder gar quantentechnischen Algorithmus.

.

So entschloss ich mich diesen Gedanken unter dem Namen „EPR-Algorithmus…“ niederzuschreiben, jedoch ohne irgendwelche Urheberschaft oder sonst etwas daran zu beanspruchen. Sollte jemand anderweitig fündig werden oder gar selbst diese Idee schon mal gehabt haben, möge er mir dies mitteilen. Ich werde umgehend die genannte Quelle verlinken und den Urheber entsprechend würdigen.

Und das EPR geht so: Alice („A“) will Bob („B“) eine Information ![]() übermitteln. Beide werden von einer zentralen Quelle aus mit verschränkten Photonen versorgt, die sie eindeutig indizieren (also „abzählen“) können. Bei jedem ankommenden Photon

übermitteln. Beide werden von einer zentralen Quelle aus mit verschränkten Photonen versorgt, die sie eindeutig indizieren (also „abzählen“) können. Bei jedem ankommenden Photon ![]() entscheidet sich Bob für eine von vier Polarisationsebenen und löst eine Messung aus. Dabei seien zwei der Polarisationsebenen für eine „Datenmessung“ gedacht, während die zwei anderen der Prüfung von Bellscher Ungleichung geschuldet seien. Bob teilt Alice die getroffene Wahl (nicht das Messergebnis) auf konventionellem Wege mit, daraufhin vergleicht Alice Bob’s Wahl mit der eigenen. Stimmen diese überein und entspricht das Ergebnis dem zu übermittelndem Bit, sendet Alice an Bob die 1, sonst die 0.

entscheidet sich Bob für eine von vier Polarisationsebenen und löst eine Messung aus. Dabei seien zwei der Polarisationsebenen für eine „Datenmessung“ gedacht, während die zwei anderen der Prüfung von Bellscher Ungleichung geschuldet seien. Bob teilt Alice die getroffene Wahl (nicht das Messergebnis) auf konventionellem Wege mit, daraufhin vergleicht Alice Bob’s Wahl mit der eigenen. Stimmen diese überein und entspricht das Ergebnis dem zu übermittelndem Bit, sendet Alice an Bob die 1, sonst die 0.

Fazit, Diskussion. Aufgabe an die Y-Generation 😉

💡 Auf den ersten Blick weist der EPR-Algorithmus eine Schwäche gegenüber dem QKD-Verfahren auf und zwar liegt der Punkt genau bei der Prüfung der Bellschen Ungleichung. Denn diese hat erst nach einer hinreichend hohen Zahl an Wiederholungen eine (statistische) Aussagekraft und das ist beim QKD-Verfahren definitorisch der Fall: Sobald man feststellt, dass die linke Seite der Bellschen Ungleichung unter 2 fällt bzw. sich diesem Wert verdächtig nähert, verwirft man den so generierten Schlüssel und macht sich auf die Suche nach dem Spion bzw. nach der objektiv vorliegenden Systemstörung.

Bei dem hier vorgeschlagenen EPR-Algorithmus ist die Sache ein Bit komplizierter, denn die Prüfung der Bellschen Ungleichung muss ja während der eigentlichen Datenübertragung quasi „zwischendurch“ erfolgen. Man kann im Falle von „Bell-Alarm“ die Übertragung sofort stoppen, aber die bis dato übertragenen Bits sind womöglich bereits in falschen Händen. Allerdings wage ich es einfach mal auszuschließen, dass eine solche Information einen praktischen Wert für irgend jemanden haben kann. Der Spion müsste ja – um die Bellsche Ungleichung nicht verdächtig werden zu lassen – jede Menge Bits einfach mal ungelesen passieren lassen, so dass ihm die restliche Information nicht wirklich was nutzt: was bringen schon 2 Bits aus einem 8-Bit-Register?

Ich denke dass sich dieser Zusammenhang – nämlich die linke Seite der Bellschen Ungleichung als Funktion vom Anteil an „mitgelesener“ Information – mathematisch würde belegen lassen. Aber da muss, fürchte ich, schon die Y-Generation ran… 😉